“두 명이 개발한 인공지능(AI) 모델이 마이크로소프트(MS), 바이트댄스, 엔비디아, 구글을 제쳤다.”(클레망 델랑그 허깅페이스 최고경영자)

한국인이 개발한 음성 합성(TTS) 모델이 미국 빅테크를 뛰어넘었다고 평가받으며 글로벌 AI업계에 화제를 낳고 있다. TTS는 텍스트를 음성으로 변환하는 기술이다. 빠르게 커지는 음성 AI 시장에서 한국이 기회를 잡을 수 있을 것이란 기대 섞인 전망이 나온다.

◇관심받는 ‘K딥보이스’

5일 AI업계에 따르면 나리랩스의 TTS 모델 ‘Dia’는 오픈소스 플랫폼 허깅페이스 다운로드 10만 건을 돌파했다. 공개 2주 만에 거둔 성과다. 나리랩스는 서울대에 재학 중인 김도엽 대표, KAIST의 성재용 대표가 공동 창업한 기업이다. 텍스트를 입력하면 AI가 자연스럽게 감정을 넣어 음성으로 변환하고 비언어적 표현(웃음, 기침 등)까지 완성도 높게 구현한다. 김 대표는 링크트인에서 “현재 상용화된 대표 TTS 서비스인 일레븐랩스와 구글 노트북LM보다 더 높은 성능을 구현했다”고 설명했다.

나리랩스는 자체 웹페이지를 통해 일레븐랩스와 Dia의 성능 비교 결과를 공개했다. 응급 상황 또는 분노, 슬픔 등 감정이 나타나는 시나리오에서 Dia는 감정선을 살리면서 균형 있는 리듬과 억양을 유지했다. 이에 비해 경쟁 모델은 문장 간 억양이 고르지 않거나 비언어 표현을 제대로 구현하지 못했다. Dia의 성능을 확인한 이선 몰릭 와튼스쿨 교수는 “또 하나의 충격적인 AI 모멘트”라며 “Dia는 내가 본 것 중 가장 표현력이 풍부한 AI 음성을 구현해냈다”고 평가했다. 실리콘밸리 벤처캐피털리스트인 디디 다스도 “Dia 모델은 완벽한 감정을 표현해낼 수 있다”고 극찬했다.

그동안 AI는 자연스러운 음성 대화를 구현하는 데 한계가 있었다. 대화 특유의 맥락과 감정 변화, 숨 쉬는 타이밍 같은 디테일이 부족해 인공적인 느낌을 지울 수 없었다. 이 문제를 해결하자고 의기투합한 두 공동대표는 아무런 투자금 없이 석 달 만에 Dia를 개발했다. 구글이 지원한 인프라를 활용했다. 김 대표는 “시중에 나온 거의 모든 TTS API(응용프로그램인터페이스)를 시험해봤지만 진짜 사람처럼 들리는 음성은 없었다”며 “Dia는 텍스트 명령어(프롬프트)만으로도 자연스러운 대화 음성을 생성할 수 있다”고 강조했다.

◇“음성 AI 시장 커질 것”

나리랩스의 시도가 주목받은 건 적은 인력과 비용으로도 인상적인 성과를 냈기 때문이다. 나리랩스는 Dia를 누구나 사용할 수 있는 오픈소스로 공개했다. 기업이 상업적 목적으로 이 모델을 활용할 수 있다는 의미다.

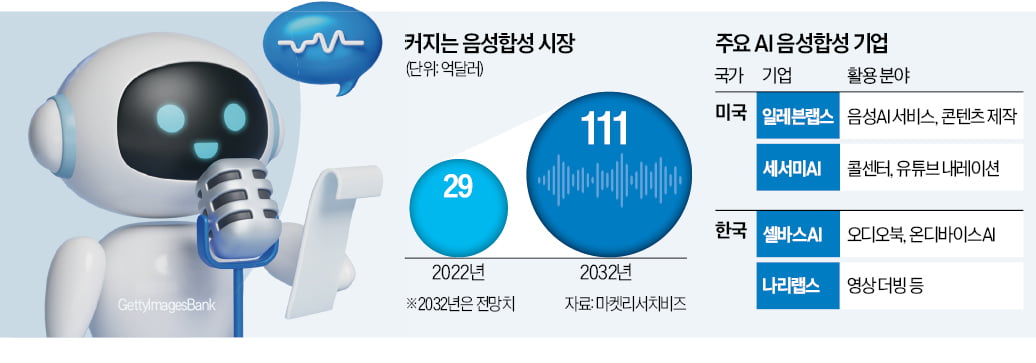

빠르게 발전하는 음성 AI 시장에 새로운 전환점이 될 것이란 전망도 나온다. 지금까진 생성형 AI가 텍스트 중심으로 발전했지만 앞으론 AI의 음성 출력 기능이 더 중요해질 것이란 얘기다. 마켓리서치비즈에 따르면 글로벌 음성합성 시장은 2032년 111억달러(약 15조원)로 불어날 것으로 예상된다. 최근 카카오의 자체 개발 멀티모달(이미지, 소리 등 여러 형태의 정보) AI 모델인 ‘카나나-o’가 글로벌 빅테크와 비슷한 성능을 보여 관심을 끌었다.

카나나-o는 음성인식, 음성합성 분야에서 오픈AI의 GPT-4o, 제미나이-1.5 프로 대비 영어와 한국어에서 모두 소폭 우위를 보였다. 감정 인식 능력에서는 주요 모델을 큰 격차로 앞섰다. 테크업계 관계자는 “음성 AI 기술은 미래에 꼭 필요한 기술이지만 보이스피싱 등에 악용될 가능성도 있어 법적, 윤리적 기준이 필요하다”고 말했다.

고은이 기자 koko@hankyung.com

7 hours ago

1

7 hours ago

1

![[속보] SKT "해킹 사태 후 현재까지 불법적 유심 복제 피해 無"](https://img.hankyung.com/photo/202505/02.22579247.1.jpg)

![[속보] SKT "유심 교체 100만명…오늘부터 대리점 신규가입 금지"](https://img.hankyung.com/photo/202505/01.40359452.1.jpg)

!['중국산=싸구려' 깨부순 남자…'드론계의 애플' 어떻게 탄생했나 [강경주의 테크X]](https://img.hankyung.com/photo/202505/01.40359678.1.jpg)

English (US) ·

English (US) ·